学習・開発の時間を短縮するディープラーニング用製品が続々登場

●門外不出の専用チップでクラウドに囲い込むグーグル 一般的なPCやサーバーのうえでも、ディープラーニングを用いたAIを動作させることは可能であり、原理的には必ずしも特別なハードウェアを必要とする技術ではない。しかし、大量のデータから特徴を自動的に抽出する部分が“肝”である以上、ディープラーニングの学習段階においては膨大な計算が必要となる。

高い精度を得るために数百万枚の画像を学習させるといった場合、通常のサーバーで処理すると数か月の時間を要することもあるという。これだけ時間がかかると、日々状況が変化するビジネスの現場でディープラーニングを適用するのは難しい。このため、原理的にはどんなマシンでも学習可能とはいえ、ディープラーニング技術を実用的に利用するには、学習時間を短縮できる並列処理に長けたハードウェアが求められる。

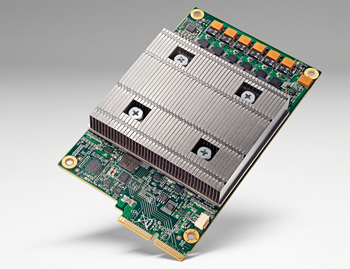

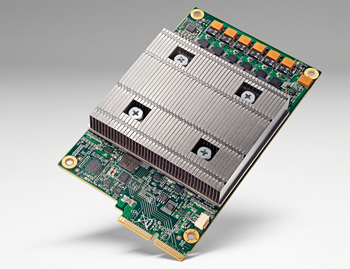

例えば、グーグルはウェブサイトの検索や「ストリートビュー」など、自社のサービスを改善するためにAIを活用しているが、学習を効率的に行うため、機械学習に特化した「Tensor Processing Unit(TPU)」と呼ぶ専用チップを独自開発した。現在のほとんどのプロセッサは32ビット/64ビット浮動小数点数の演算で高い効率を発揮するが、ディープラーニングでは演算精度を落としても学習結果に大きな違いがないケースが多いといい、グーグルのTPUも演算精度を抑えてトランジスタ数を削減し、電力あたりの学習効率を高めたものとされている。グーグルの各種ウェブサービスのほか、囲碁プログラム「AlphaGo」の学習にもTPU搭載マシンが使われたことが発表されている。

グーグルが開発した機械学習専用チップ「TPU」

ただし、グーグルはTPUを他社には販売しない方針で、TPUを使いたい開発者は、グーグルのパブリッククラウド・Google Cloud Platformの「Cloud Machine Learningサービス」を通じて利用するしかない。また同社は今月、日本語を含む機械翻訳サービスにニューラルネットを導入し、従来に比べはるかに人の言葉に近い訳文が得られるようにしたほか、画像認識APIの使用料金の大幅値下げなどを発表している。AWS、Azure、Bluemixなど他の大手クラウド事業者も機械学習には力を入れているが、グーグルはTPUという門外不出のハードウェアを武器として、ユーザーを同社のクラウドに誘導する戦略のようにみえる。

●GPU搭載サーバーはCADからディープラーニング用へ グーグルが、いわば“クラウドネイティブ”なディープラーニングのプラットフォームを垂直統合型で提供しようとしているのに対し、オンプレミスからクラウドまでさまざまな形態で実装でき、パートナーを巻き込んだディープラーニングのエコシステムを築いているのがNVIDIAだ。

同社の主力製品であるGPUは、その名の通りグラフィック処理に特化したプロセッサだ。製品にもよるが、GPU1個あたり数百から数千基の演算ユニットを搭載しており、汎用的なCPUに比べると並列処理に強いという特徴があった。この特性を生かし、同社ではGPUをグラフィック処理ではなく物理現象のシミュレーションや金融工学に応用する「GPUコンピューティング」に2000年代後半から力を入れていた。ディープラーニングでも、学習にGPUを使うことで、CPU単体での学習よりも「10倍以上」の高速化が可能という。

薄型ながら4枚のGPUカードを搭載できるデルの1Uサーバー

このことからサーバーメーカー各社も、かつてはHPC(ハイパフォーマンスコンピューティング)用途や、CAD/CG用のVDI基盤向けに販売していたGPU搭載サーバーを、ディープラーニングの学習用サーバーとして提案する動きを始めている。GPUは発熱や消費電力が大きいパーツのため、電源ユニットや冷却機構にも高い性能が求められる。メーカー独自の設計ノウハウが発揮できる分野であり、ディープラーニング需要の高まりはコモディティ化が進むサーバー市場における久々の朗報となっている。

NVIDIAが今年春にリリースした、“Pascal”のコードネームで呼ばれる同社最新世代のGPUは、演算精度を16ビット浮動小数点に抑える代わりにスループットを向上させる機能を備えるなど、従来製品以上にディープラーニングを意識したアーキテクチャとなっている。同社は19インチラック3Uサイズのきょう体に、Pascal世代のGPUを8個搭載した「ディープラーニング専用スーパーコンピュータ」や、自動運転車開発用の車載ディープラーニング基盤なども発売しており、3Dグラフィックス技術の会社からディープラーニングの会社へと転身を図りつつある。

[次のページ]